GEO in der Praxis: Was ist LLMs.txt? (R)evolution oder Hype?

Während wir SEO perfektioniert haben, ändert sich das Spiel gerade grundlegend. ChatGPT, Claude und andere KI-Systeme werden zur neuen "Suchmaschine" – und sie hätten gerne passendere Inhalte. LLMs.txt könnte helfen - aber funktioniert das wirklich? Konkrete Praxisdaten zu Traffic-Steigerungen durch ChatGPT, offizielle Unterstützung durch Anthropic und überraschende Ergebnisse aus einem 30-Tage-Experiment. Ist GEO (Generative Engine Optimization) die nächste SEO-Revolution – oder nur Marketing-Hype?

LLMs.txt: GEO bzw. SEO-Evolution oder Hype? - Ein Praxistest

In der Welt der Suchmaschinenoptimierung zeichnet sich eine fundamentale Veränderung ab. Während wir uns in den letzten 15 Jahren darauf konzentriert haben, unsere Websites für Google und andere Suchmaschinen zu optimieren, steht nun ein neuer "Nutzer" vor der Tür: Künstliche Intelligenz. Mit LLMs.txt wurde ein Standard vorgeschlagen, der Websites dabei helfen soll, ihre Inhalte optimal für Large Language Models (LLMs) wie ChatGPT, Claude oder Gemini bereitzustellen. Doch funktioniert das wirklich – oder ist es nur weiterer KI-Hype?

Was ist LLMs.txt überhaupt?

Stellen Sie sich LLMs.txt wie eine Sitemap für Künstliche Intelligenz vor – nur besser. Während eine klassische sitemap.xml lediglich Links auflistet, enthält eine llms.txt-Datei strukturierte Markdown-Inhalte, die KI-Systeme direkt verwerten können. Es ist sozusagen eine Zusammenfassung der wichtigsten Inhalte Ihrer Website, optimiert für maschinelles Lernen.

Die Datei wird im Root-Verzeichnis einer Website platziert (z.B. www.ihre-domain.de/llms.txt) und dient als zentrales Inhaltsverzeichnis. Große Sprachmodelle können so auf einen Blick erkennen, welche Produkte, Dienstleistungen, Blog-Artikel oder andere wichtige Informationen eine Website bietet – und das in einem Format, das sie besonders effizient verarbeiten können.

Der kontroverse Start: Skepsis vs. Realität

Die Einführung von LLMs.txt wurde von Anfang an kritisch beäugt. Skeptiker argumentierten, dass keine der großen KI-Plattformen offiziell ihre Unterstützung zugesagt habe und dass klassische SEO-Praktiken wie eine gute Sitemap vollkommen ausreichen würden.

Sogar Googles John Mueller äußerte sich skeptisch und stellte fest, dass derzeit kein Google-KI-System LLMs.txt aktiv nutze. Einige Experten verglichen den neuen Standard sogar mit dem berüchtigten Meta-Keywords-Tag – einem längst überholten SEO-Relikt ohne praktischen Nutzen.

Das Experiment: 30 Tage Praxistest mit überraschenden Ergebnissen

Die Web-Entwicklungsagentur Sygnal wollte es genau wissen und führte ein aufschlussreiches Experiment durch. Über einen Zeitraum von 30 Tagen implementierten sie auf ihrer eigenen Website zwei Dinge:

- Eine llms.txt-Datei als kontrolliertes Inhaltsverzeichnis

- Markdown-Versionen für jede einzelne Seite ihrer Website

Dann warteten sie ab – ohne Ankündigungen, ohne Benachrichtigungen an Google oder andere Suchmaschinen.

Die Ergebnisse sprechen für sich

Nach nur 30 Tagen zeigten sich deutliche Aktivitäten:

Top 3 der aktivsten Crawler:

- META/Facebook

- OpenAI's GPTBot

- Googlebot

Besonders bemerkenswert: Obwohl Google offiziell keine Unterstützung für LLMs.txt zugesagt hatte, landete Googlebot auf Platz 3 der aktivsten Crawler für die Markdown-Seiten.

Messbarer Anstieg des Traffics

Noch wichtiger als reine Crawler-Aktivitäten sind natürlich Auswirkungen auf menschlichen Traffic. Das Team bei Sygnal konnte einen Anstieg von Nutzer-Verweisen identifizieren:

- 53 Verweise von chatgpt.com

- 8 Verweise von Perplexity

Die Implementierung von LLMs.txt stand eindeutig in Zusammenhang mit einem signifikanten Anstieg an identifizierbarem Traffic von KI-Plattformen – insbesondere von ChatGPT und Perplexity. Die absoluten Zahlen sind natürlich in Relation zu den gesamten Verweisen der klassischen Referrals zu sehen, aber erstens ging es vor allem darum, nachzuweisen, dass es tatsächlich einen Einfluss gibt und zum anderen nutzen immer noch die meisten Menschen klassische Suchmaschinen.

Die Perspektive der KI-Entwickler: Anthropic gibt grünes Licht

Während die Diskussion in SEO-Kreisen kontrovers blieb, sprach die KI-Industrie selbst eine klare Sprache. Anthropic, das Unternehmen hinter Claude, forderte Mintlify – ein führender Anbieter von Dokumentationslösungen – explizit dazu auf, sowohl llms.txt als auch llms-full.txt zu implementieren.

Diese Anfrage ist ein starkes Signal: Wenn die Unternehmen, die führende KI-Systeme entwickeln, aktiv nach diesen Standards verlangen, geht es nicht mehr nur um theoretische Überlegungen, sondern um messbare Verbesserungen in der Interaktion zwischen KI und Webinhalten.

Das Tracking-Unternehmen Profound bestätigte durch Daten, dass Modelle von Microsoft, OpenAI und anderen aktiv llms.txt- und llms-full.txt-Dateien crawlen und indexieren.

SEO ist nicht GEO: Warum traditionelle Optimierung nicht ausreicht

Ein zentrales Missverständnis in der Debatte ist die Annahme, dass traditionelle SEO-Praktiken ausreichen würden. Die Realität sieht anders aus:

Beispiel Vercel: 10% aller Neuanmeldungen kommen mittlerweile von ChatGPT – und das durch gezielte GEO-Maßnahmen (Generative Engine Optimization), nicht durch klassisches SEO.

Fundamentale Unterschiede:

- LLMs benötigen Klarheit, Kontext und Struktur auf völlig andere Weise als traditionelle Suchmaschinen

- Bei Mintlify beobachtet man, dass Dokumentation heute zu 50% für Menschen und zu 50% für LLMs geschrieben wird – mit jeweils unterschiedlichen Optimierungsansätzen

- Vereinfachte Textdateien bedeuten weniger Tokens, schnellere Antworten und geringere Kosten für KI-Systeme

Unternehmen wie Windsurf haben hervorgehoben, dass llms.txt Zeit und Tokens spart, weil KI-Agenten nicht mehr durch komplexes HTML navigieren müssen.

Die Weiterentwicklung: llms-full.txt schlägt llms.txt

Eine interessante Entwicklung zeigt die Daten von Profound: LLMs greifen sogar noch häufiger auf llms-full.txt zu als auf die ursprüngliche llms.txt-Datei.

Der Unterschied:

- llms.txt: Listet auf, welche Seiten gecrawlt werden sollen

- llms-full.txt: Enthält den kompletten Klartext-Inhalt der gesamten Website in einer einzigen Markdown-Datei für schnellere Verarbeitung

Diese Datei wurde ursprünglich von Mintlify in Zusammenarbeit mit Anthropic entwickelt, die einen einfacheren Weg suchten, ihre komplette Dokumentation in LLMs einzuspeisen, ohne HTML parsen zu müssen. Nach dem Erfolg wurde sie für alle Kunden ausgerollt und in den offiziellen llmstxt.org-Standard aufgenommen.

Für wen lohnt sich LLMs.txt?

Nicht jede Website profitiert gleichermaßen von LLMs.txt. Der Standard funktioniert am besten, wenn:

- Ihre Website textlastig ist und wertvollen Content bietet

- Alle Inhalte öffentlich zugänglich sind (nicht hinter Paywalls oder Login)

- Der Inhalt für Nutzer von KI-Systemen relevant ist (z.B. zur Beantwortung von Fragen)

Typische Anwendungsfälle:

- Wissensportale

- Blog-Inhalte

- Produktkataloge

- Technische Dokumentationen

Weniger geeignet (aktuell):

- Fotografen-Portfolios

- Reine Medien-Websites ohne substantiellen Text

Die Implementierung: Von manuell bis vollautomatisch

Statische Lösung

Es ist sehr einfach, eine llms.txt-Datei oder Markdown-Dateien mit manuell erstellten Inhalten zu hinterlegen. Das ist natürlich aufwendig, aber damit kann der Inhalt eben auch umfassend gesteuert werden, sinnvoll für Inhalte, die sich selten ändern und bei denen manuelle Optimierung gefragt ist. Der Nachteil: Bei jeder Änderung muss die Datei eben auch manuell aktualisiert werden.

Dynamische Lösung mit Pre-Rendering

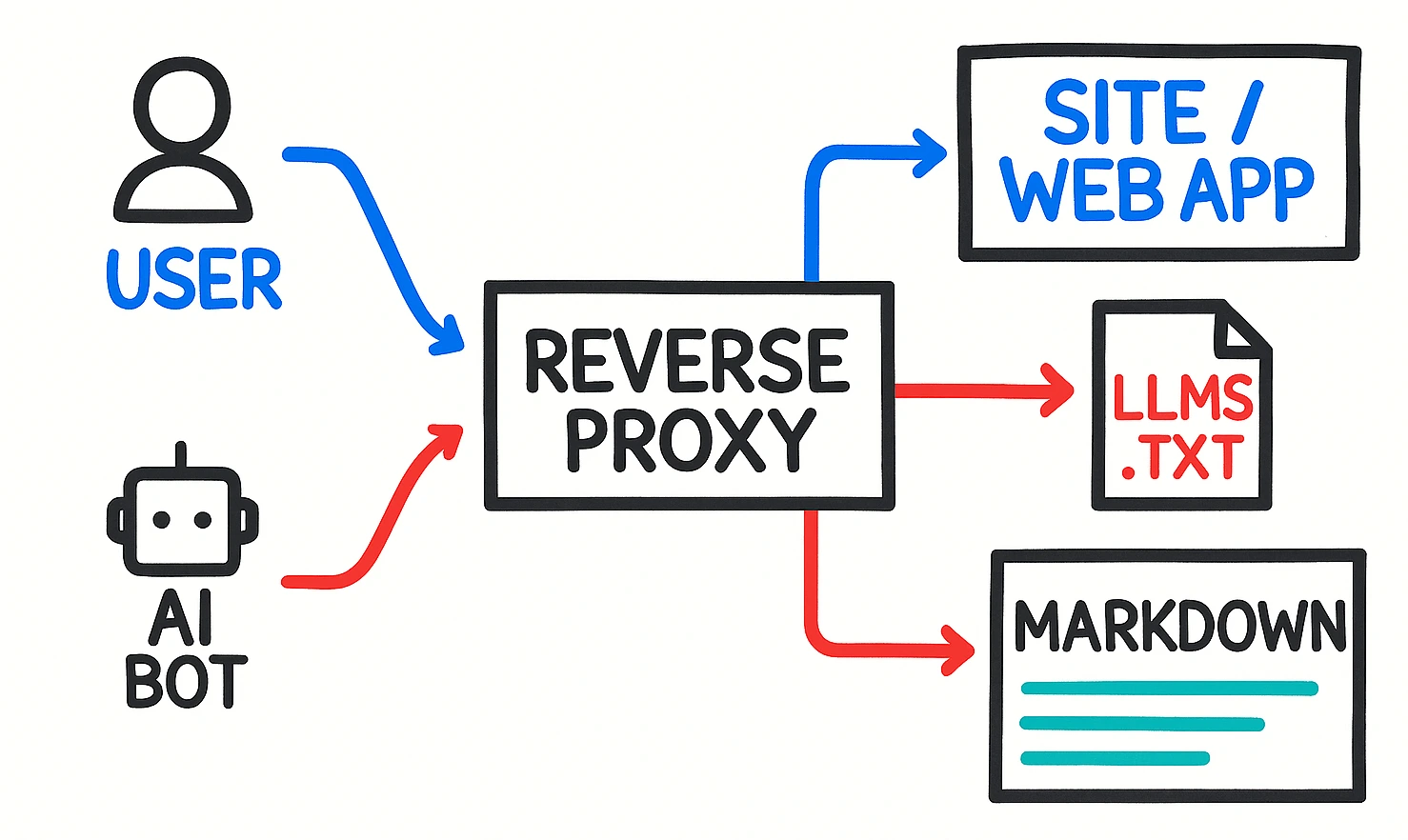

Fortschrittlichere Ansätze wie z.B. mit unserer Pre-Rendering Infrastruktur im ownStack-Framework können so aussehen:

- Anfragen von AI-Crawlern werden anhand des Agent-Strings identifiziert und mit einem Reverse-Proxy umgeleitet, für diese Requests wird dann:

- Eine llms.txt-Datei generiert und aktualisiert.

- Für jede Url eine entsprechende AI-optimierte Markdown-Version des Inhalts erstellt. Das kann auf Basis von speziellen Templates geschehen die z.B. bereits verfügbare Produktdaten in einer passenden Struktur ausgeben oder in Form separater Felder aus einer Datenbank oder einem CMS mit AI-Inhalten - oder man kombiniert beide Ansätze.

- Bei jeder Änderung (neue Blog-Artikel, Produktaktualisierungen) werden automatisch die Inhalte aktualisiert.

Wir nutzen eine sehr ähnliche Architektur (Pre-Rendering für dynamische, browserbasierte Apps), um klassischen Search-Engine-Crawlern optimierte Inhalte für das Indexieren zur Verfügung zu stellen - gerade bei Web-Apps und SPAs reicht die Analysefähigkeit der Crawler sonst oft nicht für optimale Ergebnisse.

Die Zukunft: Mehr als nur Textdateien

Die Entwicklung von LLMs.txt steht erst am Anfang. Experten erwarten folgende Entwicklungen:

Kurzfristig:

- Standardisierung von Datumsangaben für aktuelle Inhalte

- Strukturen für wichtige Alerts und Sonderangebote

- Erweiterte Unterstützung für Medien wie Fotos und Videos

Mittelfristig:

- Abfragemöglichkeiten: LLMs könnten gezielt nach bestimmten Produkten oder Themen suchen

- Spezifikationen für Markdown-Seiten mit Metadaten zu Lizenzierung, Attribution und Quellenangaben

Langfristig:

- Websiteintegrierte Agenten (ähnlich MCP / Model Context Protocol)

- Funktionen wie Angebotserstellung, Warenkorbverwaltung oder Account-Management direkt über KI

Fazit: Hype oder echte Revolution?

Die Daten sprechen eine klare Sprache: LLMs.txt ist mehr als nur Hype. Die praktischen Erfahrungen zeigen:

- Messbare Ergebnisse: Nachweislicher Anstieg von KI-generiertem Traffic

- Aktive Nutzung: Große KI-Unternehmen wie Meta, OpenAI und Google crawlen diese Dateien aktiv

- Industriestandard: Führende KI-Entwickler wie Anthropic fordern die Implementierung

- Echte Business-Effekte: Unternehmen wie Vercel generieren bereits 10% ihrer Anmeldungen über ChatGPT

Ja, es gibt berechtigte Fragen zur Standardisierung und nicht alle Plattformen haben ihre Unterstützung offiziell kommuniziert. Aber die Realität zeigt: Wer heute auf LLMs.txt setzt, verschafft sich einen Wettbewerbsvorteil – und in naher Zukunft wird es zum Standard gehören.

Wir stehen an einem ähnlichen Wendepunkt wie vor 15 Jahren, als SEO für traditionelle Suchmaschinen zum Standard wurde. Damals haben diejenigen profitiert, die früh auf den Zug aufgesprungen sind. Die Geschichte scheint sich zu wiederholen – nur dass diesmal KI-Systeme die neuen "Nutzer" sind, die wir ansprechen müssen.

Die Frage ist nicht mehr, ob LLMs.txt Sinn macht, sondern wann wir damit anfangen.

P.S.: Auch unsere Website hat mittlerweile eine automatisch generierte LLMs-full.txt erhalten.

AI-Disclaimer

Wir nutzen AI-Technologien als Unterstützung bei der Recherche und Entwicklung von Texten für diesen Blog. Die Ergebnisse werden immer genau geprüft und von einem Menschen verantwortet.

Claude hat für mich die Urls, die ich recherchiert und analysiert hatte, übersetzt und zusammengefasst. Wir haben dann noch Details zu dynamischem Pre-Rendering ergänzt und Chad hat das passende Diagramm mit den Requests erstellt.

LLMS.TXT + Webflow | Sygnal Technology

llms.txt Proposed Standard | Search Engine Land

https://searchengineland.com/llms-txt-proposed-standard-453676

The value of llms.txt: Hype or real? | Mintlify

https://www.mintlify.com/blog/the-value-of-llms-txt-hype-or-real

The /llms.txt file